08-04-2013, 2:26 AM

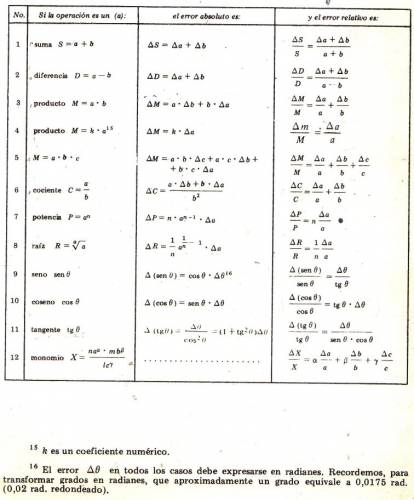

La incertidumbre o error de una medida, es un valor que estima los posibles valores de una medida. Se suele denotar con la letra griega delta minúscula \( (\delta) \).

Forma general:

$$ (a ± \delta a) b $$

Siendo:

· \( a \) = la medida.

· \( \delta a \) = la incertidumbre de la medida.

· \( b \) = la unidad de la medida.

Ejemplo:

Cuando medimos con una regla (las reglas generalmente tienen una incertidumbre de \(\delta l = ± 0,1 cm \)), si medimos 10 cm de algo, la longitud de ese tal algo, será de \( (10 ± 1) cm \).

Forma general:

$$ (a ± \delta a) b $$

Siendo:

· \( a \) = la medida.

· \( \delta a \) = la incertidumbre de la medida.

· \( b \) = la unidad de la medida.

Ejemplo:

Cuando medimos con una regla (las reglas generalmente tienen una incertidumbre de \(\delta l = ± 0,1 cm \)), si medimos 10 cm de algo, la longitud de ese tal algo, será de \( (10 ± 1) cm \).